Neste post, será explicado como criar uma pipeline de dados para transferir dados do OData de uma fonte Northwind para um destino Lakehouse.

Pré-requisitos

Antes de começar, certifique-se de atender aos seguintes pré-requisitos:

- Tenha um workspace habilitado pelo Microsoft Fabric, diferente do Workspace padrão.

Siga as etapas abaixo:

O primeiro passo é criar um Lakehouse, que é um data lake otimizado para análises e será usado neste post como destino para o fluxo de dados.

Acesse o workspace habilitado pelo Fabric.

Selecione Lakehouse no menu novo item.

Insira um Nome para o lakehouse.

Selecione criar.

Com o Lakehouse criado , o próximo passo é configurar o fluxo de dados.

- Configuração de um Fluxo de Dados

Um fluxo de dados é uma transformação de dados reutilizável que pode ser integrada a um pipeline. Nessa etapa será criado um fluxo que extrai dados de uma fonte OData e os armazena em um Lakehouse como destino.

Acesse o workspace habilitado pelo Fabric.

Selecione Fluxo de Dados Gen2 no menu novo item.

Ingestão de Dados da Fonte OData

Selecione Pagina Inicial/Obter Dados e, em seguida, selecione Mais.

Informe a URL da fonte OData. Utilize o seguinte endereço: serviço de exemplo OData

Selecione próximo.

Selecione a entidade a ser ingerida. Neste caso, escolha a entidade Orders.

Selecione Criar.

Com os dados da fonte OData ingeridos, será configurado o destino Lakehouse.

Para ingerir os dados no destino lakehouse:

- Selecione Adicionar destino de dados.

- Selecione Lakehouse.

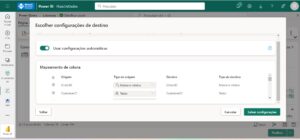

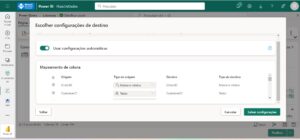

Configure a conexão desejada para se conectar ao Lakehouse. As configurações padrão são adequadas.

Selecione Próximo.

Navegue até o workspace que foi criado o lakehouse.

Selecione o lakehouse que foi criado na etapa anterior.

Confirme o nome da tabela.

Selecione Próximo.

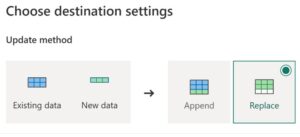

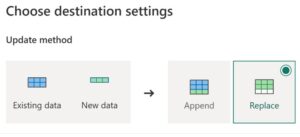

Confirme o método de atualização e selecione Salvar configurações.

Publique o fluxo de dados.

Observação:

“Quando o primeiro Fluxo de Dados Gen2 é criado em um workspace, os itens do Lakehouse e Warehouse são automaticamente provisionados, juntamente com seus modelos semânticos e pontos de extremidade de análise SQL relacionados.

Esses itens são compartilhados por todos os fluxos de dados no workspace, sendo essenciais para o funcionamento do Fluxo de Dados Gen2 e não devem ser excluídos ou utilizados diretamente pelos usuários.

Eles são parte da implementação interna do Fluxo de Dados Gen2. Embora não sejam visíveis no workspace, podem ser acessados em outras ferramentas, como notebooks, pontos de extremidade SQL, Lakehouse e Warehouse.

Esses itens podem ser identificados pelo prefixo no nome, que é “DataflowsStaging”.

Com os dados ingeridos no destino Lakehouse, é possível avançar para a configuração do pipeline de dados.

- Criando uma Pipeline de Dados

Um pipeline de dados é um fluxo de trabalho projetado para automatizar o processamento de informações de forma eficiente.

Nesta etapa, será criada uma pipeline de dados para executar o Fluxo de Dados Gen2 configurado no procedimento anterior.

Acesse a página de visão geral do workspace e escolha “Pipelines de Dados” no menu de criação

Informe um nome para o pipeline de dados.

Selecione a atividade “Fluxo de Dados”.

Escolha o Fluxo de Dados criado no procedimento anterior na lista suspensa “Fluxo de Dados” nas Configurações.

- Executando e Agendando a Pipeline de Dados.

Nesta etapa, a pipeline de dados será executada e agendada, permitindo a execução conforme o agendamento definido na configuração.

Vá até o workspace criado.

Abra o menu suspenso do pipeline de dados que foi criado no procedimento anterior e selecione Aplicar.

Defina o agendamento desejado para executar a pipeline de dados.

Com a pipeline de dados criada, ela será executada conforme o agendamento configurado, atualizando os dados no lakehouse.

Para verificar o status do pipeline de dados, acesse o Hub de Monitoramento. Também é possível consultar o status ao acessar “Pipeline de Dados” e selecionar a guia “Histórico de Execução” no menu suspenso.

Até o próximo post.

#SempreEmMovimento

#MicrosoftFabric

#MVPBuzz